Hintergrund: Was wir über Apples Vision Pro und visionOS wissen

(Bild: Apple)

Apples teure Wette auf "räumliches Computing": Alle wichtigen Details zu Vision-Pro-Hardware, Software – und der Mixed-Reality-Konkurrenz.

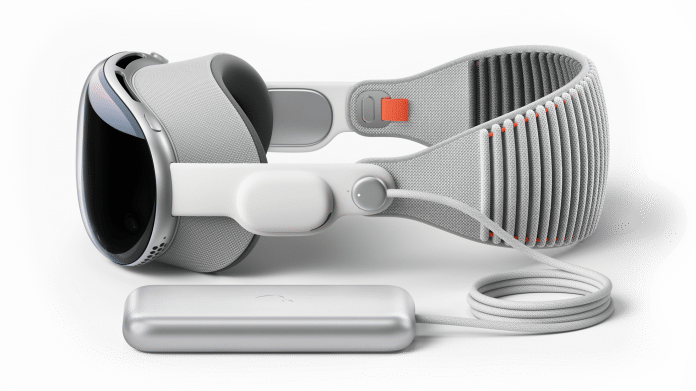

Die Vision Pro ist zweifellos das ambitionierteste und komplexeste Apple-Produkt seit der Einführung des iPhones vor über 15 Jahren. Am 2. Februar ist es nun soweit: Apple schickt mit der Vision Pro eine neue Gerätekategorie ins Rennen, vorerst nur in den USA. Das Basismodell mit 256 GByte Speicherplatz wird für 3500 US-Dollar gehandelt, weitere Preisstufen sind noch nicht bekannt. Auch zum Euro-Preis und einem Termin für den Start in Deutschland liegen bislang keine Informationen vor.

Auch wenn Apple den Begriff "Virtual Reality" nicht in den Mund nimmt: Die Vision Pro ist ein VR-Headset mit Passthrough- Modus, sie erfasst die physische Außenwelt über Kameras sowie weitere Sensoren und stellt sie auf zwei Bildschirmen vor den Augen des Trägers dar. Apple setzt dabei auf eine besonders hohe Auflösung sowie geringe Latenz. Dabei steht Augmented Reality respektive Mixed Reality im Vordergrund, also digitale Elemente wie Apps, die in der eigenen Umgebung erscheinen – "räumliches Computing". Aber auch Virtual Reality, also das Eintauchen in eine komplett digitale Welt, ist stufenweise möglich, etwa für Filme, Spiele oder einfach als Hintergrund für Apps.

Bislang unübertroffene Display-Technik

Um dreidimensionale filmische Szenen wie auch virtuelle Arbeitsumgebungen mit der Realität zu vereinen, mit ihnen interagieren und gegebenenfalls mit den Menschen darin kommunizieren zu können, analysiert die Vision Pro die Umgebung des Nutzers sowie dessen Hand- und Augenbewegungen mit insgesamt zwölf Kameras, sechs Mikrofonen und fünf Sensoren. Zu diesen zählt beispielsweise ein LiDAR-Scanner, der anhand ausgesandter Lichtpulse und der Zeit, bis sie auf Objekte treffen und zu ihm zurückgeworfen werden, eine 3D-Karte der Umgebung erstellt.

(Bild: Apple)

Doch jenseits der technischen Raffinessen zählt zu den grundlegenden Herausforderungen, denen sich alle Headset-Designer stellen müssen, zunächst das Gewicht. Immer noch gibt es dazu keine genauen Angaben, im Raum stehen rund 500 Gramm. Einen ungewöhnlichen Schritt geht Apple damit, den Akku in ein externes Aluminium-Case auszulagern. So belastet der Akku allenfalls die Hosentasche oder sogar nur das Möbel, auf dem er liegt. Vorteilhaft dürfte sich zudem auswirken, dass man einen externen Akku zum Laden abziehen und leichter gegen einen vollen austauschen kann. Während sich das geflochtene Kabel vom Headset lösen lässt, ist es mit dem Akku offenbar fest verbunden. Zur Kapazität ist noch nichts bekannt, die Laufzeit liegt den Angaben zufolge bei zwei Betriebsstunden, die Wiedergabe von 2D-Videos soll bis zu 2,5 Stunden lang möglich sein. Über USB-C lässt sich das Akku-Pack mit dem Stromnetz verbinden, um die Vision Pro länger verkabelt im Betrieb zu halten.

- Die Vision Pro stellt Außenwelt und VR-Inhalte auf zwei hochaufgelösten Displays dar.

- Die Steuerung erfolgt vorrangig über Augen-Tracking und Gesten.

- Kameras und Sensoren erfassen kontinuierlich die physische Umgebung sowie Augen- und Handbewegungen.

- Viele iOS-Apps laufen direkt in visionOS, das App-Angebot wird entsprechend groß sein.

- Neben 2D-Apps unterstützt die Vision Pro auch Virtual-Reality-Anwendungen und 3D-Inhalte.

(Bild: Apple)

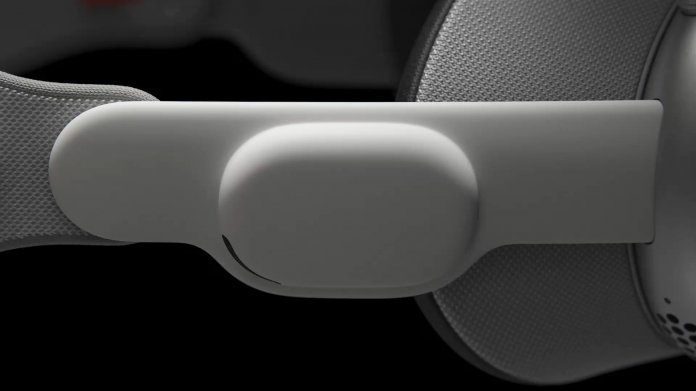

Am Headset sitzt der proprietäre Connector für das Anschlusskabel am linken Bandanschluss, der wiederum das Headset mit einem austauschbaren Kopfband verbindet. Apple will das Kopfband in unterschiedlichen Größen anbieten, ein seitliches Drehrad (Fit Dial) sorgt dann noch zusätzlich für einen festen Sitz. Zusätzlich legt Apple ein Band bei, das zusätzlich auch über den Kopf läuft. Es dürfte das Gewicht besser verteilen und ein Abrutschen des Headsets verhindern. Atmungsaktive Textilmaterialien sollen vermeiden, dass man schnell schwitzt.

Der Rahmen besteht aus einer Aluminiumlegierung. Um das gebogene, aber starre Gehäuse an unterschiedliche Kopfformen und -größen anschmiegen zu können, will Apple auch den weichen Lichtschutz in unterschiedlichen Größen und Passformen anbieten und verbindet ihn per Magnetschließe mit dem Gehäuse. An der Unterseite des Rahmens sieht das thermische Design Lüftungsschlitze vor.

Mixed Reality vereint die virtuelle mit der realen Welt

Für das Verschmelzen der virtuellen Welt mit der persönlichen Umgebung verbergen sich im Rahmen hinter dem gebogenen laminierten Glas, das sich durchgängig über die gesamte Front erstreckt, die eingangs erwähnten Sensoren, Kameras und Mikrofone. Während Letztere unter anderem für das Audio Raytracing bestimmt sind und Sprachbefehle entgegennehmen, erfassen schräg und nach unten gerichtete Kameras die Gesten, mit denen der Nutzer ohne weitere Hardware Schaltflächen drücken oder virtuelle Objekte greifen und bewegen kann. Bei schwachem Umgebungslicht unterstützen Infrarotstrahlen das Erfassen der Gesten.

(Bild: Apple)

Zwei mechanische Bedienelemente sitzen oben rechts und links auf dem Aluminiumrahmen des Headsets: Drückt der Headset-Träger die Digital Crown, die dem gleichnamigen Bedienelement der Watch nachempfunden ist, erscheint der Homescreen; dreht er an ihr, verändert sich der Grad der Verschmelzung zwischen dem realen Raum und sogenannten Environments, sprich Umgebungen. Das sind Landschaften, in die der Nutzer mithilfe der Vision Pro eintauchen kann.

(Bild: Apple)

Eine flache Taste auf der linken Seite löst die Kamera für eine Foto- oder Videoaufnahme aus. Kameras und Mikrofone nehmen die Bilder und den zugehörigen Ton ebenfalls dreidimensional auf. Damit wird die Vision Pro zugleich zu einer stereoskopischen Kamera. Den Protagonisten bleibt die Aufnahme nicht verborgen, denn wie eine blinkende LED beginnt das Visier des Headsets optisch zu pulsieren. Besitzer eines iPhone 15 Pro und 15 Pro Max können bereits solche räumlichen Aufnahmen mit dem Smartphone anfertigen.

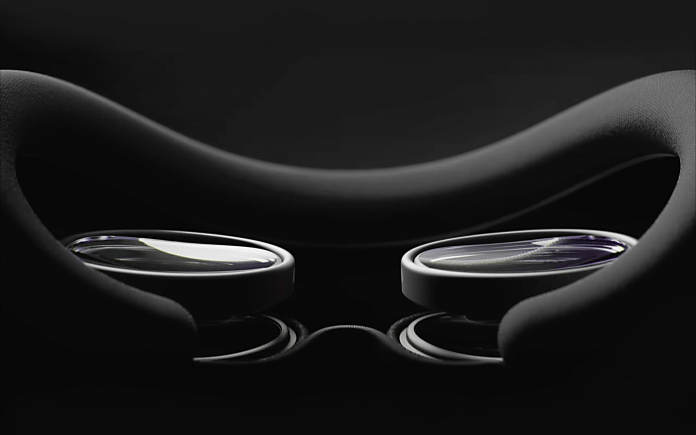

Die Projektionsfläche für sogenannte immersive Videos – 3D-Videos in 180 Grad mit Spatial-Audio – vermittelt laut Apple den Eindruck einer 30 Meter breiten Leinwand. Für diese Illusion blickt man im Inneren des Headsets auf zwei Ultra-HD-Displays, deren Größe Apple mit der einer Briefmarke vergleicht. Dass sie trotzdem jeweils mit 4K auflösen, ist möglich, weil jedes der insgesamt 23 Millionen Pixel nur 7,5 Mikrometer breit ist. Damit stehen einem einzelnen iPhone-Pixel 64 Micro-OLED-Pixel gegenüber.

Das Headset unterstützt sowohl Standard- (SDR) als auch High-Dynamic-Range-Inhalte (HDR). Die Bildwiederholrate liegt laut Apple bei mindestens 90 Hertz. Für die Wiedergabe von Videos mit 24 Bildern pro Sekunde lässt sie sich auf 96 Hertz erhöhen. Für den dreidimensionalen Effekt geben die beiden Micro-OLED-Displays dieselbe Szene mit etwa dem gleichen optischen Versatz wieder, der beim Betrachten der realen Welt das Bild im linken Auge von dem im rechten unterscheidet – das Grundprinzip von 3D. Unterschiede in den Details, die jedes Auge wahrnimmt, verstärken den Tiefeneindruck und das räumliche Empfinden.

Vision Pro per Eye-Tracking steuern

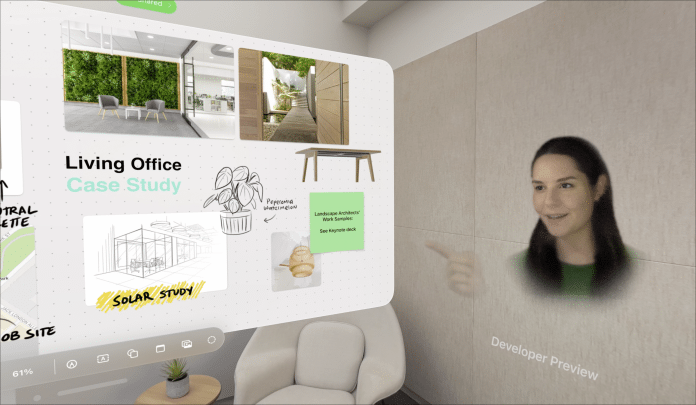

Neben Filmen wird das Betriebssystem visionOS auch Apps ausführen sowie etwa Bildschirminhalte eines auf dem Schreibtisch stehenden Macs wiedergeben. Dabei will Apple in 4K gerenderte Texte auch beim Lesen aus unterschiedlichen Betrachtungswinkeln scharf darstellen. Möchte man mit einem Button interagieren, um beispielsweise eine Option zu aktivieren, muss man die Schaltfläche zunächst mit den Augen anvisieren. Um das wiederum systemseitig zu erkennen, sitzt um die Innendisplays herum jeweils ein Ensemble von LEDs und vier Infrarotkameras, die permanent nicht sichtbare Lichtmuster auf die Augen projizieren. Sobald nun die Augen auf eine Schaltfläche oder ein bewegliches Objekt fokussieren, können die Hände über Gesten darauf einwirken.

(Bild: Apple)

Privatsphäre und Sicherheit

Je nachdem, in welcher virtuellen Welt man sich gerade bewegt, könnte es einen beunruhigen, dass die Vision Pro den eigenen Blicken folgt. Das weiß auch Apple und verspricht: Wo Anwender hinschauen, während sie das Headset nutzen, bleibt vertraulich und die Informationen des Augen-Trackings werden nicht mit Apple, Apps von Drittanbietern oder Webseiten geteilt. Beim sogenannten Eye Input fokussiert der Nutzer ein Objekt und kann es anschließend mit einer Handgeste auswählen oder aktivieren. Das Rendering, um das anvisierte Objekt gegenüber dem Nutzer erkennbar hervorzuheben, übernimmt ein Systemprozess, ohne die betreffende App darüber zu informieren. Sie erfährt nur von der abschließend per Handgeste getroffenen Auswahl – wie bei einem Mausklick.

Neue Authentifizierung per Optic ID

Aus dem Sensoren-Ensemble zieht Apple noch einen weiteren Nutzen und führt ein neues biometrisches Authentifizierungsverfahren ein: Um die Vision Pro zu entsperren oder Käufe im App Store zu tätigen, vergleicht das System die LED-Lichtaufnahmen der Iris mit einer neuen Optic ID, einem Iris-Scan. Wie Touch ID (Fingerabdruck) und Face ID (Gesichtsscan) verbleiben die Optic-ID-Daten verschlüsselt auf dem Gerät. Sie liegen vom Hauptprozessor isoliert und für Apps unzugänglich in der Secure Enclave des SoCs (System on a Chip). Entwickler können nicht auf sie zugreifen. Sie können aber, wie auch auf dem iPhone, die gerätespezifische Authentifizierung (hier also per Optic ID) durch das System anfragen, um etwa die Überweisung durch eine Banking-App zu autorisieren.

Digitales Abbild des Nutzers

Apple scannt nicht nur die Iris en détail. Auch wenn es für Dritte im Raum so erscheinen soll: Das Visier der Vision Pro ist nicht durchsichtig. Niemals könnte also eine weitere Person im Raum die Augen dahinter sehen, denn diese blicken auf zwei Mini-Displays. Was außenstehende Personen zu sehen bekommen, ist eine Projektion der Augenpartie des Nutzers in dem linsenförmigen OLED-Panel auf dem Frontglas. EyeSight heißt die neue Vokabel im Apple-Dictionary, zu der die Übersetzen-App auf dem iPhone "Sehkraft" auswirft. Eine spezielle Politur versieht das gebogene OLED-Panel mit einer lentikularen Linse, die für den Betrachter ein Prismenrasterbild erzeugt. Wie bei Fun-Postkarten, die mit diesem Effekt gezielt verblüffen, ändert sich mit der eigenen Bewegung auch die Perspektive des betrachteten Objekts – in diesem Fall der Augen des Nutzers. So vermittelt das Prismenrasterbild einer anderen Person den Eindruck, in direktem Blickkontakt mit dem Nutzer zu stehen, unabhängig davon, ob sie frontal auf das Headset schaut oder aus einem leicht schrägen Blickwinkel. Displays sind jedoch gemeinhin auch die größten Energieverbraucher. Und so weist Apple den nach außen gerichteten Bauteilen eine weitere Aufgabe zu und wertet ihre Signale zusätzlich dahingehend aus, ob sich eine Person dem Nutzer zuwendet. Nur wenn das der Fall ist, erhellt sich das Display und zeigt die digitalisierte Augenpartie des Nutzers dahinter.

(Bild: Apple)

Ähnliches vollzieht sich bei FaceTime noch einmal deutlich verschärft. Denn visionOS zeigt den Träger in Videokonferenzen gänzlich ohne Headset. Für dieses Bild kombiniert die Software die aktuelle Mimik des Nutzers mit dessen Gesicht, das die Vision Pro bereits im Vorfeld scannen und speicheren kann: Damit Apples TrueDepth-Kamera mit einer Kombination aus Infrarotkamera, Punktprojektor und RGB-Kamera detaillierte Tiefeninformationen über das Gesicht des Nutzers erfassen kann, muss man sich der Vision Pro beim ersten Anmeldeprozess einmalig präsentieren, als würde man ihr gegenüberstehen. Nur so kann das Headset den Kopf vollständig rendern, um einen möglichst lebensechten Avatar zu erzeugen. Aus diesem dreidimensionalen Abbild des Nutzers, seiner Mimik und den Händen entsteht dann zur Laufzeit ein digitales Ebenbild. Apple nennt dieses Alter Ego Persona. Damit soll nicht nur die Kommunikation im hauseigenen Facetime möglich sein, sondern auch in gängigen Apps wie Microsoft Teams, Zoom und Webex.

Zeiss Optical Inserts

Nicht nur für die bestmögliche Wahrnehmung der Projektion durch den Nutzer, sondern auch für das Eyetracking ist es wichtig, dass die Vision Pro eventuelle Sehfehler wie eine Brille korrigiert. Hierfür lässt Apple von dem deutschen Optikunternehmen Zeiss spezielle Linsen fertigen. Die Zeiss Optical Inserts werden sich magnetisch vor die Innendisplays ansetzen lassen. Das kostet – je nach Korrekturglas – 100 bis 150 US-Dollar Aufpreis.

(Bild: Apple)

Im Headset selbst verwendet Apple katadioptrische Linsen. Sie sind sehr flach, weshalb man auch von Pancake-Linsen spricht. Gegenüber Fresnel-Linsen, wie sie unter anderem in der Meta Quest 2 sitzen, bieten sie prinzipiell ein kleineres Sichtfeld, sind jedoch weniger anfällig für chromatische Aberrationen, die überlappende Farben und Geisterbilder hervorrufen können. Mit der Quest 3 hat übrigens auch Meta bei den verwendeten Linsen einen Wechsel von Fresnel zu Pancake vollzogen.

Hardware im Detail

Das Zimmer und die Menschen darin, die Augen hinter dem Visor des Nutzers – diese Bilder erschafft die Vision Pro mit der Rechenpower eines Dual-Chip-Designs. Die Leistung erbringt Apples M2-Chip, der aktuell unter anderem im MacBook Air und Mac mini steckt.

Für ein möglichst verzögerungsfreies Zusammenspiel der Sensoren steht dem leistungsfähigen M2 ein zweites Herzstück zur Seite: Der neue R1 widmet sich voll und ganz den Signalen von Sensoren, Kameras und Mikrofonen. Wer schon einmal länger ein AR- oder VR-Headset getragen hat, stellte unter Umständen nach einiger Zeit ein leichtes Unwohlsein fest. Dazu kann es kommen, wenn die Wahrnehmung durch die verschiedenen Sinne nicht übereinstimmt. Wenn man etwa den Kopf dreht und sich das Bild, das die Augen sehen, nicht augenblicklich mitbewegt. Je nach Empfindlichkeit können sich bereits geringe Latenzzeiten negativ auswirken, dafür muss der Nutzer sie nicht mal bewusst wahrnehmen.

(Bild: Apple)

Die Geschwindigkeit, mit der der R1 Bild und Ton der Umgebung zum Nutzer überträgt, also auf die beiden Innendisplays und die integrierten Lautsprecher, bezeichnet Apple als achtmal schneller als ein Wimpernschlag und beziffert sie mit 12 Millisekunden. Zum Vergleich: Berührungen nehmen wir mit etwa 140 bis 150 Millisekunden wahr, optische Reize mit durchschnittlich 180 bis 200 Millisekunden. Das unterstreicht die Geschwindigkeit von Apples Real-Time-Verarbeitung. Dabei darf man nicht vergessen, dass die Vision Pro nicht nur einfach die Bilder von außen nach innen überträgt; viel mehr kombiniert sie alle Kamerabilder mit den Informationen des LiDAR-Scanners, um die reale Welt mit den digitalen Inhalten dreidimensional zu verschmelzen.

Audio Raytracing passt den Klang an die Umgebung an

Akustisch verstärkt Audio Raytracing das Raumempfinden und stimmt den Hall der virtuellen Realität etwa auf ein gefliestes Zimmer ab oder auf eines mit Teppichboden und schweren Vorhängen. Genau genommen müsste es Wavetracing heißen, denn während Raytracing eigentlich berechnet, wie sich Lichtstrahlen an den verschiedenen Gegenständen und Oberflächen der näheren Umgebung brechen und von ihnen reflektiert werden, geht es hier um die Wirkung des Interieurs auf die Schallwellen, ob ein Möbel sie etwa schluckt oder verstärkt. Ambient Spatial Audio weist der Geräuschquelle dann noch eine Richtung und Entfernung zu.

(Bild: Apple)

Die beiden Dual-Treiber-Audio-Pods sitzen auf dem Bandanschluss etwas vor und über den Ohren, weshalb einem nicht entgeht, wenn jemand den Raum betritt oder einen anspricht. Der flexible Bandanschluss soll gewährleisten, dass die Audio Pods ohne zu drücken nah am Kopf sitzen können. Dual-Treiber bedeutet, dass sie einen Treiber für die hohen und mittleren Töne besitzen und einen eigenen für die tiefen. Damit sie optimal wirken, kann der Nutzer unter Zuhilfenahme eines iPhones mit TrueDepth-Kamera ein 3D-Audioprofil erstellen, das die Ausgabe auf die eigene Kopf- und Ohrengeometrie abstimmt. Will er sich vollkommen abschotten oder sicherstellen, weitere Personen um ihn herum nicht zu stören, kann er die Vision Pro natürlich auch mit AirPods koppeln.

(Bild: Apple)

Hardware von Sony

Details zu einzelnen Komponenten hat Apple nicht genannt und wird die Namen womöglich auch niemals preisgeben. Der Twitter-User INSIDERSONY spricht von folgenden Komponenten, die wir jeweils kurz erläutern:

| Komponente | Eigenschaften | Beschreibung |

| Sony Inner Display | 1.3 Inch Silicon-Based OLED | Internes Display, das auf Silizium basiert und OLED-Technologie verwendet. Es ist 1,3 Zoll groß. |

| Sony IMX418 | Fisheye IR, 6DoF-Tracking | Bildsensor mit Fisheye-Infrarot-Fähigkeiten, der für 6DoF-Tracking (6 Degrees of Freedom) verwendet wird. Das bedeutet, dass er Bewegungen in alle sechs Freiheitsgrade erfasst: vorwärts, rückwärts, aufwärts, abwärts, seitwärts und Drehungen. |

| Sony Eye-Tracking | WLO Package | Augenverfolgungssystem, das in einem WLO-Paket (Wafer Level Optics) untergebracht ist und präzises Eye-Tracking in kompakten Geräten ermöglicht. |

| Sony Face-Tracking | WLO Package | Ein Gesichtsverfolgungssystem, das in einem WLO-Paket (Wafer Level Optics) untergebracht ist. Es ermöglicht präzises Face-Tracking in kompakten Geräten. |

| Sony IMX418 | Fisheye IR, Torso-Tracking | Bildsensor mit Fisheye-Infrarot-Fähigkeiten, der speziell für die Verfolgung des Oberkörpers (Torso) verwendet wird. |

| Sony IMX611 | dToF, ToF | ToF-Bildsensor (Time of Flight), der dToF-Technologie (direct Time of Flight) verwendet. Er misst die Zeit, die ein Lichtsignal benötigt, um von einem Objekt reflektiert zu werden und zum Sensor zurückzukehren. Er wird zur Tiefenwahrnehmung und 3D-Abbildung verwendet. |

visionOS: Apples räumliches Betriebssystem

visionOS ist praktisch iOS in 3D: Mit dem neuen Betriebssystem für die Vision Pro baut Apple ganz auf vertraute Elemente, sodass sich iPhone-, iPad- und Mac-Nutzer unmittelbar zu Hause fühlen. Ein Druck auf die digitale Krone des Headsets öffnet jederzeit die Home-Ansicht mit den eigenen Apps. Darunter befinden sich die Apple-Programme Fotos, Notizen, Mail und Nachrichten, Einstellungen, der Browser Safari sowie ein für die Vision Pro aufgebauter neuer App Store. Auch Apples noch junge Whiteboard-App Freeform ist mit an Bord, ebenso wie die Streaming-Dienste des Herstellers (Music und TV-App). iCloud synchronisiert im Hintergrund die Daten, um alle Apps auf dem neuesten Stand zu halten, wie man es von Apples anderen Betriebssystemen gewohnt ist.

(Bild: Apple)

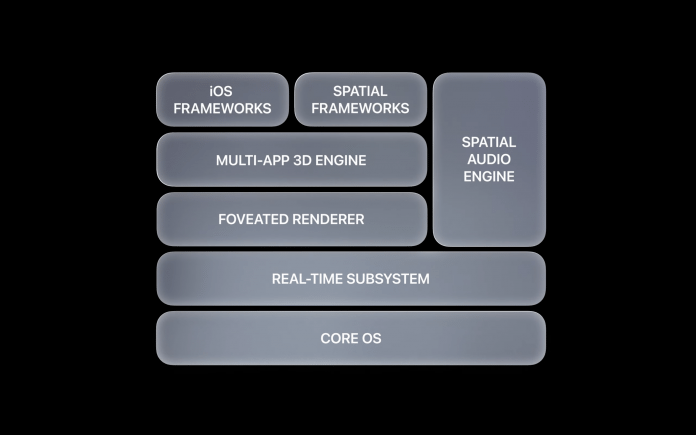

Neben dem Core OS, das Apple für alle Betriebssysteme verwendet, integriert visionOS auch eine Echtzeitkomponente zur Einbindung der Kamera- und Sensordaten. Darüber hinaus sorgt die Rendering-Technik Foveated Rendering dafür, dass das System das, worauf die Augen gerade schauen, in höchstmöglicher Qualität darstellt. Bereiche, die nur im Augenwinkel erscheinen, können in niedrigerer Auflösung gerendert werden, um Rechenleistung zu sparen. Weitere Elemente von visionOS sind eine 3D-Engine für die gleichzeitige App-Darstellung im Raum sowie die für räumliches Computing angepassten Frameworks mitsamt einer Engine für 3D-Audio. Zum Unterbau von visionOS zählen zudem etliche iOS-Frameworks. Dadurch laufen viele iPhone- und iPad-Apps einfach so als 2D-Apps auf dem Headset, entsprechend groß dürfte das Software-Angebot gleich vom Start weg sein – Apple spricht von über 1 Million Apps. Natürlich steht Entwicklern offen, ihre Apps für das neue Betriebssystem anzupassen, damit diese etwa automatisch auf die Beleuchtung der physischen Umgebung reagieren – und mit einem als "Glas" bezeichneten, leicht durchsichtigen Hintergrund insgesamt optisch besser zum räumlichen visionOS passen.

(Bild: Apple)

Wie auf iPhone und iPad ist die Home-Ansicht anpassbar und unterstützt Ordner. Links neben den App-Icons blendet visionOS eine kleine vertikale Steuerleiste ein, die einen schnellen Wechsel zu den Kontakten (für FaceTime-Videokonferenzen) sowie den Environments erlaubt. Diese Umgebungen sind gewissermaßen die Wallpaper für visionOS, sie überlagern auf Wunsch das Live-Bild der hinter den Apps sichtbaren physischen Umgebung. Zu diesen Environments gehören Natursehenswürdigkeiten wie Mount Hood und Szenerien aus den Nationalparks Joshua Tree und Yosemite ebenso wie generische Strandbilder und die Mondoberfläche. Die Umgebungen besitzen bewegte Elemente wie Regen und scheinen eine Mischung aus statischen Aufnahmen sowie computergenerierten Elementen zu sein – mitsamt Sound. Der Träger bestimmt durch das Drehen an der digitalen Krone, wie immersiv diese Umgebungen erscheinen, also ob sie nur Teile oder aber das gesamte Blickfeld ausfüllen sollen. Letztlich sind die Umgebungen als Hintergrund für ein fokussiertes Arbeiten mit den 3D-Apps gedacht, schließlich lässt sich so die physische Umgebung – etwa das gerade nicht aufgeräumte Büro – einfach ausblenden.

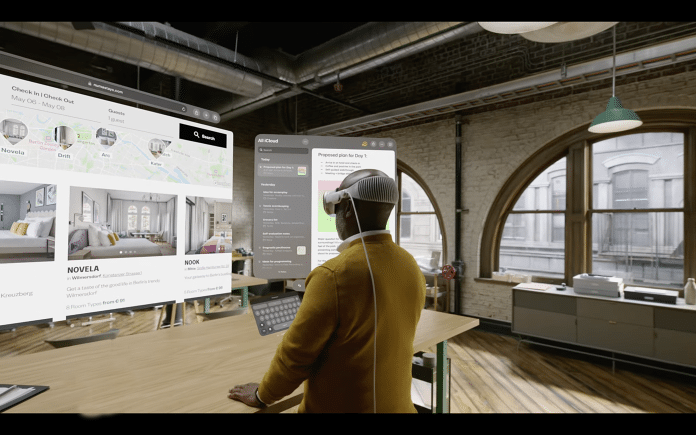

Fenster, 3D-Objekte, VR-Apps

Apps öffnen sich in großen Fenstern, die in der physischen Umgebung schweben, die das Kamerasystem der Vision Pro erfasst und auf die beiden Displays vor den Augen projiziert. Im Unterschied zu einem oder mehreren klassischen Monitoren gibt es hier keine Begrenzung für die Fenster. Sie lassen sich also frei in der eigenen Umgebung platzieren, und zwar rundherum sowie an verschiedenen Orten. Die Fenster sollen dabei exakt an der gewählten Position verharren, bis der Nutzer sie wieder neu platziert. Das erlaubt, sehr ausladende und spezifische virtuelle Arbeitsumgebungen einzurichten und sich etwa aus dem Arbeits-Setup im Homeoffice mit bestimmten offenen Fenstern physisch ins Wohnzimmer zu begeben, wo zum Beispiel bereits die Fotos-App und eine Streaming-App als offene Fenster an der zuvor dafür gewählten Stelle warten. Ob es ähnlich wie in iPadOS eine Obergrenze für die Zahl der gleichzeitig geöffneten Fenster gibt, bleibt vorerst offen. Ebenso ist noch nicht bekannt, wie lange und zuverlässig visionOS die gewählten Fensterpositionen speichert, ob diese etwa Neustarts und Abstürze überstehen und wie sich alle Fenster mit einem Schlag schließen lassen. Vom Mac vertraute Fensterverwaltungsfunktionen wie Mission Control – eine Schnellübersicht aller geöffneten Fenster – hat Apple bislang nicht für visionOS gezeigt.

(Bild: Apple)

Über ein kleines, automatisch erscheinendes Bedienelement ändern Nutzer bei Bedarf die Größe der Fenster, das funktioniert ähnlich wie in Stage Manager auf dem iPad. visionOS blendet zudem zwei feste Bedienelemente unter jedem Fenster ein: Ein weißer Punkt ist zum Schließen eines Fensters gedacht. An dem länglichen weißen Balken holt man es näher heran, schiebt es weiter weg oder richtet das Fenster im Raum frisch auf den eigenen Blickwinkel aus, wenn man etwa seine Kopfposition geändert hat. Apps bringen Bedienelemente wahlweise in sogenannten Ornaments unter, die an einer Fensterseite erscheinen und Zugriff auf verschiedene Ansichten und Funktionen geben. In der Fotos-App wechselt man so zum Beispiel von der Mediathekansicht zu den Alben. Das entspricht der Tab-Leiste, die in vielen iPhone-Apps zu finden ist.

(Bild: Apple)

Apps können auf der Vision Pro zweidimensional bleiben, haben aber die Option, 3D-Elemente in der Fensteransicht zu integrieren. Ferner ist es möglich, dreidimensionale Objekte – etwa Auto- oder Flugzeugmodelle – frei in den Raum zu bringen, die sich von allen Seiten betrachten lassen. App-Entwickler platzieren solche 3D-Objekte in sogenannten Volumes, die man sich als großen Würfel vorstellen kann. Neben dem Multitasking mit mehreren Apps respektive den Fenstern verschiedener Apps ist auch die Arbeit mit einzelnen Programmen im Vollbild vorgesehen: Dann liefert ein Programm alle im Raum erscheinenden Inhalte – etwa mehrere Fenster und 3D-Objekte – und sorgt wahlweise auch für eine Hintergrundumgebung, die die physische Welt komplett überdeckt und ausblendet. Das entspricht einer klassischen Virtual-Reality-Anwendung, Apple nennt das "fully immersive".

(Bild: Apple)

Einschränkungen für VR-Spiele

Für VR-Apps und besonders VR-Spiele gibt es in visionOS besondere Hürden: Bewegt sich der Nutzer schnell oder geht auf ein Hindernis zu, blendet die Vision Pro automatisch wieder das Live-Bild der physischen Umgebung ein, um eine mögliche Kollision etwa mit einem Möbelstück zu vermeiden. Entsprechend ist das Headset im VR-Modus auf einen recht statischen Einsatz ausgelegt. Insgesamt kann sich der Headset-Träger in einem VR-Spiel nach Apples Dokumentation nur rund anderthalb Meter von seinem Startpunkt wegbewegen, bis Vision Pro automatisch die Außenwelt einblendet. Um das Headset in einem sich schnell bewegenden Objekt zu verwenden, wie Flugzeug, Zug oder Auto, gibt es einen speziellen Reisemodus, der bestimmte Funktionen abschaltet und ebenfalls voraussetzt, dass man in seinem Sitz verbleibt. Zudem liefert Apple keine VR-Controller mit, was zumindest viele bestehende VR-Spiele zwingend zur Steuerung benötigen.

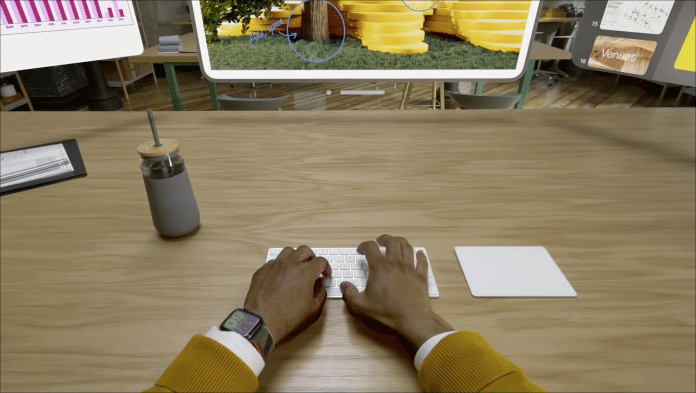

iOS- und visionOS-Apps laufen direkt auf dem M2-Chip des Headsets. Eine Besonderheit gibt es im Zusammenspiel mit dem Mac: Dessen Bildschirminhalt kann die Brille groß in 4K in einem einzelnen Fenster im Raum darstellen, wie Apple vorführte. Das soll Trägern der Vision Pro letztlich auch die Arbeit mit mächtigen macOS-Anwendungen ermöglichen. Wie reibungslos und latenzfrei das in der Praxis funktioniert, bleibt abzuwarten.

visionOS steuern – mit Augen, Gesten und mehr

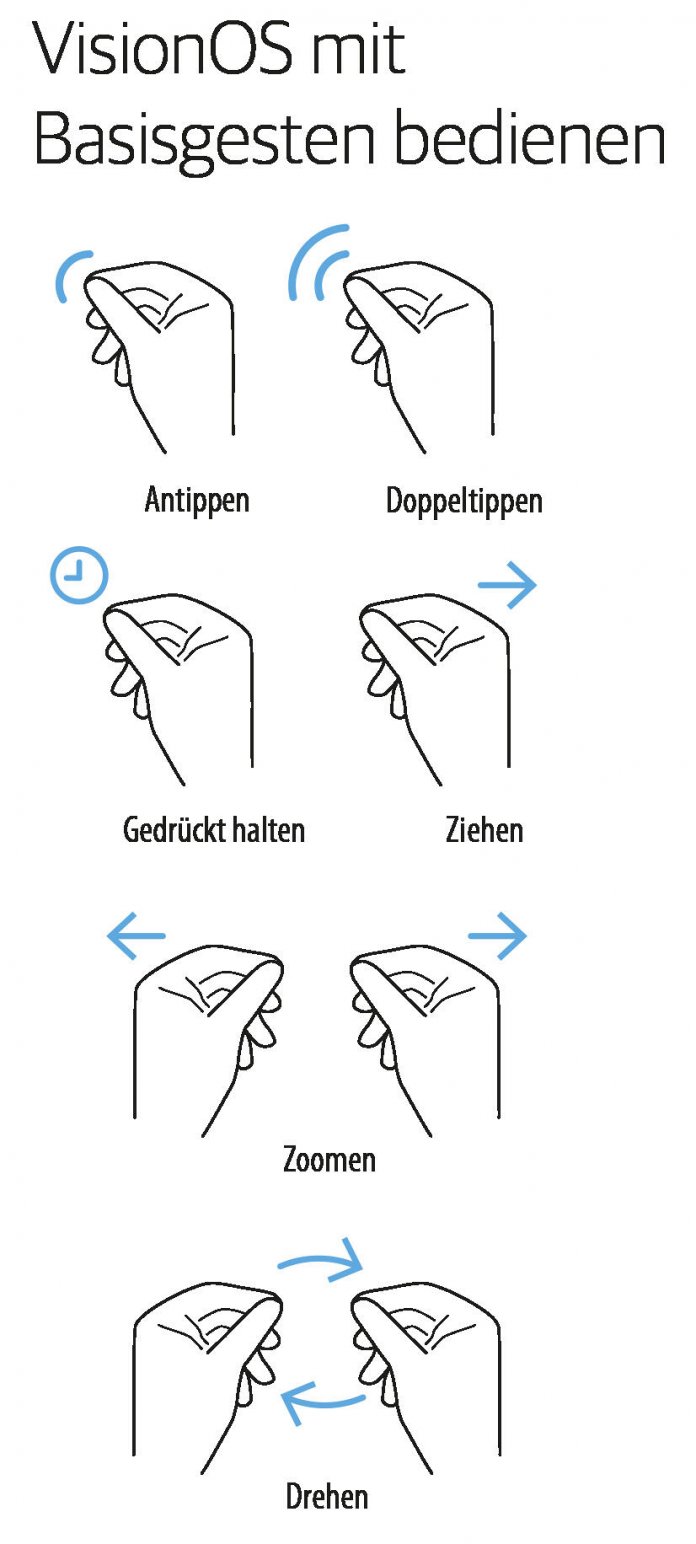

Die Steuerung von Apps in visionOS erfolgt mit Augen, Gesten und Sprachbefehlen. Die Eingaben werden über die Kamera- und Sensorensysteme des Headsets erfasst. Das Betriebssystem hebt die Bedienelemente hervor, auf die die Augen gerade fokussieren. Bringt der Headset-Träger nun Zeigefinger und Daumen in einer Zwickgeste zusammen, führt visionOS die Aktion aus. Das fühlt sich offenbar sehr natürlich an, die Lernkurve scheint gering, gerade für iPhone-Nutzer. Es gibt weitere Gesten unter anderem zum Scrollen, Zoomen und Verschieben von Inhalten (siehe Grafik).

(Bild: Apple)

Die Gesten funktionieren auch, ohne dafür die Arme erst vor die Augen respektive die Hauptkameras des Headsets zu heben. Es reicht, sie etwa mit den Händen bequem auf dem Schoß auszuführen, die Vision Pro hat dafür extra zwei nach unten gerichtete Kameras. Entwickler können obendrein eigene Handgesten für Virtual-Reality-Apps definieren sowie auch Daten über die Beschaffenheit der Umgebung abfragen, um etwa 3D-Objekte auf einem physischen Tisch zu platzieren. Das kennen Nutzer bereits von Augmented-Reality-Apps für das iPhone, dafür kommt ebenfalls Apples ARKit zum Einsatz. Direkten Zugriff auf die Kameras erhalten Apps in visionOS aber nicht. Dem Hand-Tracking durch Dritt-Apps müssen Nutzer erst zustimmen.

Neben solchen indirekten Gesten ist auch eine direkte Steuerung von Apps mit den Fingern vorgesehen, die ähnlich wie die Touch-Bedienung von iPhone und iPad funktioniert. Dafür muss man die Fenster nahe genug an sich heranziehen, um die Bedienoberfläche direkt zu "berühren". So ist zudem die Interaktion mit 3D-Objekten möglich. Für die Texteingabe hat visionOS ein virtuelles Keyboard mit an Bord. Alternativ diktiert man Siri den Text etwa für ein Suchfeld oder steuert mit Sprachbefehlen Systemaktionen wie Apps starten und beenden. Demonstriert hat Apple das allerdings noch nicht.

(Bild: Apple)

Auf Fingergesten allein muss man sich bei visionOS aber nicht verlassen, gerade für längere Texteingaben, das Ausführen von Tastenkürzeln oder die Arbeit mit Profi-Apps sind klassische Eingabegeräte klar von Vorteil. Das Betriebssystem unterstützt dafür Hardware-Tastaturen, Trackpads und Mäuse – alles wohl rein über Bluetooth. Der auf zweidimensionale Bedienoberflächen ausgelegte Mauszeiger arbeitet hier im Zusammenspiel mit dem Augen-Tracking: Wechselt der Blick von einem Fenster zu einem anderen, springt auch der Cursor dorthin.

Game-Controller etwa von Xbox und Playstation lassen sich ebenfalls per Bluetooth verbinden. Spezielle VR-Controller, die man in beiden Händen hält, hat Apple bislang weder selbst gezeigt noch eine Unterstützung für Geräte von Drittherstellern in Aussicht gestellt.

Apples SDK verrät, dass für visionOS weitere aus iOS bekannte Elemente geplant sind, darunter das Kontrollzentrum zur schnellen Ansteuerung von Systemfunktionen sowie eine Mitteilungszentrale, die Benachrichtigungen sammelt. Das SDK sieht außerdem einen Gastmodus vor, der dafür gedacht ist, die Vision Pro vorübergehend einer anderen Person zu geben. Ein richtiger Mehrbenutzermodus, der es erlaubt, zwischen verschiedenen Profilen und Konfigurationen zu wechseln, scheint allerdings nicht geplant zu sein.

Vision Pro im Alltag

Meta vermarktet seine VR-Headsets als eine Option für Unternehmen, um an entfernten Orten sitzende Mitarbeiter in virtuellen Meetings zusammenzubringen. Sie sollen sich im dreidimensionalen Raum viel persönlicher anfühlen als zweidimensionale Zoom- und Teams-Konferenzen. Von solchen Szenarien hat Apple bislang nur wenig gezeigt.

(Bild: Apple)

Klar ist aber, dass Vision Pro und visionOS darauf ausgelegt sind, mehrere an anderen Orten sitzende Headset-Träger in einem virtuellen Raum zu versammeln. Dafür kommt die weiter oben bereits beschriebene eigene digitale Persona zum Einsatz sowie Apples SharePlay-Technik zum Teilen von Inhalten etwa über FaceTime. Statt nur zweidimensional in Fenstern zu erscheinen, können die Personas dann gemeinsam in einem virtuellen Raum Platz nehmen, wie Apple gegenüber Entwicklern erklärte – das lasse die Teilnehmer tatsächlich präsent wirken. Wie bei einem physischen Meeting soll das eine Kommunikation über Körpersprache und Mimik erlauben. Dafür gibt es mehrere Vorlagen für SharePlay-Apps, um die Anordnung der Personen rund um einen geteilten Inhalt zu bestimmen. Das reicht von einem Setting, bei dem alle nebeneinander aufgereiht sitzen und etwa gemeinsam eine Präsentation (oder einen Spielfilm) ansehen, bis zu einem Kreis an digitalen Personas, die um ein 3D-Objekt herumstehen. Auch eine "Konversationsvorlage" gibt es, die die Teilnehmer im virtuellen Raum ähnlich wie in einem Meeting vor einem Whiteboard anordnet. Diese Funktionen scheinen bei Apple noch in der Entwicklung zu stecken, vorgeführt wurde davon – außer dem FaceTime-Gespräch – nämlich nichts. Entsprechend bleibt hier etwa offen, ob Apples digitale Personas auch Beine besitzen oder ähnlich wie ursprünglich bei Metas Horizon Workrooms vorerst ohne solche Körperteile auskommen müssen.

Zur Produktstrategie von Apple gehört seit der Rückkehr von Mitbegründer Steve Jobs im Jahr 1997 die Fähigkeit, den richtigen Moment abzuwarten, um mit einem neuen Produkt an die Öffentlichkeit zu gehen. Der iPod war nicht der erste MP3-Player auf dem Markt. Vor dem iPhone gab es schon andere Smartphones. Das iPad war nicht der erste Tablet-Computer, die Apple Watch nicht die erste Computeruhr. Und vor den AirPods gab es ebenfalls schon drahtlose Kopfhörer. In allen genannten Beispielen gelang es aber Apple in wenigen Jahren, mit ausgefeilten Produkten und innovativen Interfaces den Startvorsprung der Konkurrenz einzuholen und sich an die Spitze zu setzen.

Apple-Chef Tim Cook setzt nun mit der Vision Pro darauf, dass dieses Muster sich wiederholen wird. Sein Unternehmen tritt gegen eine Reihe von Wettbewerbern an, die zum Teil schon seit Jahren Brillen für Virtual Reality (VR), Augmented Reality (AR) oder Mischformen (Mixed Reality, XR) anbieten. Am relevantesten dürften der Facebook-Konzern Meta und der ewige Rivale Microsoft sein. In dem Markt tummeln sich aber etliche Player, etwa aus dem Games-Umfeld (Sony, Valve, HTC) oder Start-ups wie Xreal.

Meta-Chef Mark Zuckerberg arbeitet seit Jahren daran, eine virtuelle Welt – das "Metaverse" – als zukünftige Computerplattform zu etablieren. Um diese Strategie zu verdeutlichen, änderte er sogar den Konzernnamen von Facebook zu Meta. Bereits 2014 hatte Zuckerberg 2,3 Milliarden Dollar in die Hand genommen, um den VR-Brillen-Hersteller Oculus VR zu übernehmen. Das ehemalige Start-up ist heute Teil des Bereichs Reality Labs bei Meta.

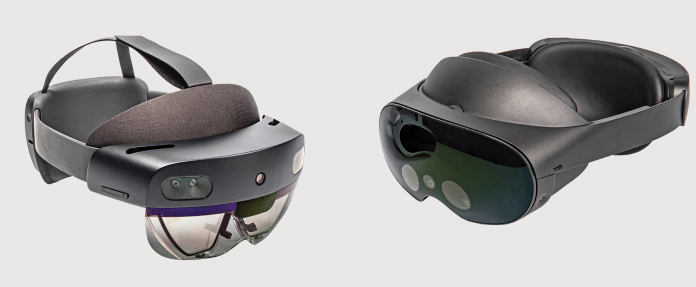

Meta tritt mit drei Datenbrillen gegen die Apple Vision Pro an: Die Quest 2, die Quest Pro und die Quest 3. Die Quest 2 kam im Herbst 2021 auf den Markt, durfte aber lange Zeit wegen eines Streits mit dem Bundeskartellamt in Deutschland nicht verkauft werden. Inzwischen ist das Einsteigermodell auch in der Bundesrepublik ab 350 Euro zu haben. Für die Quest Pro, die mit einer höheren Auflösung und Leistung, mehr Komfort und besseren Controllern punktet, verlangt Meta in Deutschland rund 1300 Euro. Die Quest 3 ist ab 550 Euro erhältlich.

Die Unterschiede liegen aber nicht nur in der Hardware. Meta sieht seine Datenbrillen vor allem als Tor zu einer abgeschlossenen virtuellen Welt, dem Metaverse. Apple-Managern kommt das Wort Metaverse dagegen nicht über die Lippen. Die Apple Vision Pro ist viel stärker darauf ausgelegt, virtuelle Elemente mit der physischen Umgebung zu verschmelzen, die mithilfe der Kameras an Nutzer durchgereicht wird. Allerdings steuert auch Metas Quest 3 mit einem deutlich verbesserten Passthrough-Modus verstärkt in diese Mixed-Reality-Richtung.

Auf die Ankündigung der Vision Pro reagierte Zuckerberg im vergangenen Jahr gelassen: "Die gute Nachricht ist, dass es keine magischen Lösungen für die physikalischen Gesetze gibt, die unsere Teams nicht schon erforscht und bedacht haben", schrieb "Zuck" an seine Mitarbeiter. Apple habe sich für ein Display mit höherer Auflösung entschieden, das siebenmal mehr koste und so viel Energie benötige, dass man eine (externe) Batterie und ein Kabel brauche, um es zu benutzen. Meta sorge mit seinen Innovationen dafür, dass die Produkte für jeden so zugänglich und erschwinglich wie möglich seien. "Und wir haben zig Millionen Quests verkauft."

Auf solche Verkaufserfolge kann sich Microsoft-CEO Satya Nadella nicht berufen. Sein Konzern war 2016 mit der HoloLens in das Geschäft mit einer Datenbrille eingestiegen, bei der es aber nicht darum ging, komplett in eine virtuelle Scheinwelt einzusteigen. Vielmehr werden bei der HoloLens virtuelle Objekte dreidimensional in die physische Umgebung eingeblendet. Nach enttäuschenden Verkaufszahlen, die auch dem hohen Preis – mit über 3500 Euro ähnlich wie bei der Vision Pro – geschuldet sind, stellte Microsoft 2019 die HoloLens in einer verbesserten Neuauflage vor.

Inzwischen ist unklar, welche Pläne Microsoft mit der HoloLens überhaupt noch verfolgt. Der führende HoloLens-Entwickler Alex Kipman hat vor gut einem Jahr das Unternehmen verlassen. Anfang 2023 gehörte das HoloLens-Team zu den Abteilungen, die am stärksten von den Massenentlassungen bei Microsoft betroffen waren.

Christoph Dernbach

Blick nach vorne

Für die Vision Pro greift Apple auf ein Fundament aus riesigem App-Ökosystem, exklusivem Content, Spezial-Chips sowie immenser Hardware-Expertise zurück. Derartiges Know-how kann kein Konkurrent vorweisen, ebenso wenig wie Apples riesige Geldbestände, die kostspielige Experimente erlauben. Das sind zumindest gute Voraussetzungen für einen langen Atem zu einem möglichen Durchbruch. Der Preis ab 3500 US-Dollar freilich weniger. Auch wenn noch nichts dergleichen konkret angekündigt ist, liegt auf der Hand, dass Apple mit dem Pro-Headset den zweiten Schritt vor dem ersten macht und eine günstigere Vision ohne Pro-Bezeichnung nachliefern wird – die Frage bleibt nur, wann.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmmung wird hier ein externer Podcast (Podigee GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Podigee GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung [8].

Zugleich ist es Apples ungewöhnlichste und riskanteste Produkteinführung der letzten beiden Dekaden: Smartphones, Tablets, Uhren und MP3-Player waren schon vor iPhone, iPad, iPod und Watch ganz offensichtlich eigene Märkte. Im Unterschied dazu bleibt offen, ob genug Leute sich einen Computer auf den Kopf und vor die Augen schnallen wollen. Extrem spannende, neue Apps und Inhalte müssen hier als Kaufanreize dienen. Dafür hofft das Unternehmen auch auf Drittanbieter. Vor allem ist die Vision Pro in Zugzwang, den hohen Preis zu rechtfertigen und zu demonstrieren, dass sie einen erheblichen Mehrwert zu bewährten 2D-Computern wie iPhone, iPad und Mac bietet.

Weitergehende Details zur Vision Pro und visionOS beleuchtet Mac & i im Podcast TNBT [9].

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmmung wird hier ein externer Preisvergleich (heise Preisvergleich) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (heise Preisvergleich) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung [10].

(bsc [11])

URL dieses Artikels:

https://www.heise.de/-9233915

Links in diesem Artikel:

[1] https://www.heise.de/ratgeber/iOS-17-iPadOS-17-und-watchOS-10-16-Tipps-fuer-den-Praxiseinsatz-9308593.html

[2] https://www.heise.de/ratgeber/iOS-17-Co-Neue-Funktionen-in-Apple-Apps-ausreizen-9309783.html

[3] https://www.heise.de/tests/iPhone-15-15-Plus-15-Pro-und-15-Pro-Max-im-Test-Leichte-Verbesserungen-9313305.html

[4] https://www.heise.de/hintergrund/Ausprobiert-Wie-der-iPhone-Satellitenfunk-Leben-retten-kann-7393605.html

[5] https://shop.heise.de/zeitschriften-abo/mac-i/

[6] https://www.heise.de/select/mac-and-i

[7] https://www.heise.de/mac-and-i/

[8] https://www.heise.de/Datenschutzerklaerung-der-Heise-Medien-GmbH-Co-KG-4860.html

[9] http://mac-and-i.de/tnbt

[10] https://www.heise.de/Datenschutzerklaerung-der-Heise-Medien-GmbH-Co-KG-4860.html

[11] mailto:bsc@heise.de

Copyright © 2023 Heise Medien