CM3Leon: Meta stellt generative KI für Text-zu-Bild und Bild-Erklärungen vor

Meta stellt eine eigene generative Bilder-KI vor. CM3Leon soll schneller sein als die Konkurrenz, bessere Ergebnisse liefern und weniger Ressourcen benötigen.

Meta steigt mit einer eigenen generativen Bild-KI in den Markt ein (CM3Leon), die präziser und schneller arbeiten soll.

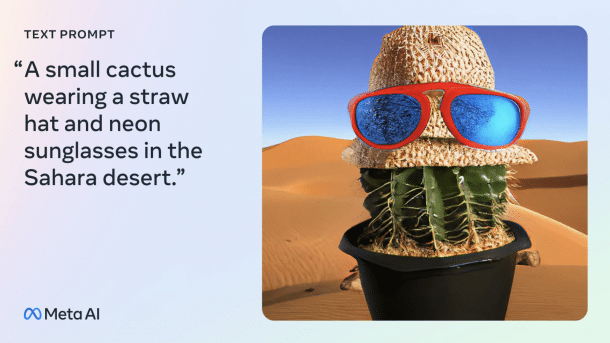

(Bild: Meta)

Meta hat ein eigenes, generatives KI-Modell für Bilderzeugung (Text-zu-Bild) und Bildbeschreibung vorgestellt und sieht sich selbst dabei der Konkurrenz deutlich voraus. Das CM3Leon getaufte Modell (ausgesprochen wie das englische "chameleon") erzeugt aus natürlicher Sprache Bilder, kann den Inhalt beliebiger Bilder sprachlich beschreiben sowie auf Anweisung Teile in einem Bild verändern oder austauschen. Bei alldem soll CM3Leon schneller und präziser arbeiten als die Konkurrenz und weniger Rechenleistung benötigen, erläutert Meta in einem Blogbeitrag, der das KI-Modell ausführlich vorstellt.

Besseres Verständnis beim Erzeugen und Erklären von Bildern

In dem Blogbeitrag (der auch auf eine wissenschaftliche Veröffentlichung zu den Hintergründen verweist) bezeichnet Meta seine KI als "Durchbruch" beim schnellen Erzeugen und Verstehen von Bildern. Die Qualität der erzeugten Bilder sei besser und näher an der zugrundeliegenden Texteingabe als bei vergleichbaren Produkten, heißt es dort. Und das Verständnis vorgelegter Bilder sei ebenfalls exakter als anderswo und eröffne auch die Möglichkeit, Bildteile auf Anweisung zu verändern.

Letzteres illustriert der Beitrag anhand des bekannten Gemäldes "Das Mädchen mit dem Perlenohrgehänge" des niederländischen Barockmalers Jan Vermeer van Delft. Mit dem Gemälde als Eingabe ergibt etwa die Frage "Wie würde sie als bärtiger Mann aussehen?" eine Antwort, bei der ein Männergesicht mit Bart verblüffend exakt in das Gemälde eingepasst ist. Zu einem Bild mit einem Hund, der einen Stock im Maul trägt, beantwortet CM3Leon die Frage "Was trägt der Hund?" korrekt. Auch beim Erzeugen von Bildern sei größere Genauigkeit möglich (etwa das Platzieren bestimmter Objekte an eine exakt benannte Stelle im Bild) und die Ergebnisse seien präziser und schärfer als bei den Konkurrenten.

CM3Leon nutzt laut Metas Auskünften ein Transformer-Modell, im Unterschied zum Diffusion-Modell, das bei der Konkurrenz zum Einsatz kommt, etwa bei der Bild-KI DALL·E 2 von OpenAI oder Imagen von Google. Beim Diffusion-Modell wird Bild-Ausgangsmaterial unter hohem Rechenaufwand von Rauschen befreit und iterativ einer Zielvorgabe angenähert. Bei einem Transformer-Modell hingegen wird in Lerndurchgängen bestimmten Elementen Aufmerksamkeit gewidmet und so das Modell trainiert; dies benötigt weniger Rechen- und Trainingsaufwand und liefert praktisch besser einsetzbare KI-Modelle. Ein Transformer-Modell für generative Bilder-KI ist einigermaßen neu und Meta gibt an, CM3Leon sei sogar im Vergleich zu anderen Transformer-KI-Modellen schneller und weniger ressourcenintensiv.

Meta trainierte seine Bilder-KI mit Millionen Quelldaten aus dem Bestand der Bildagentur Shutterstock. CM3Leon habe laut Meta bis zu 7 Milliarden Parameter aus den Trainingsdaten gelernt, mehr als doppelt so viele wie DALL·E 2. Eine weitere Besonderheit von CM3Leon ist die Nutzung überwachter Feinabstimmung (Supervised Fine-tuning, SFT), die sonst eher in Text-KI wie ChatGPT zum Einsatz kommt. Meta konnte SFT für die Bilderzeugung und -beschreibung nutzen und damit einerseits die Verarbeitungsgeschwindigkeit erhöhen, andererseits verbesserte Bildbeschreibung und textbasierte Bildveränderung erzielen.

(tiw)